In diesem Dokumente beleuchten wir den Nutzen von Evaluation und Feedback bei der Entwicklung eines Angebots. Nachfolgend erläutern wir verschiedene Evaluations- und Feedbackinstrumente, die wir für ProXLab-Angebote entwickelt haben. Wir geben zu jedem Instrument ein Anwendungsbeispiel aus unserem Projektkontext und liefern wertvolle Tipps zum Einsatz in universitären und betrieblichen Kontexten.

1. Hintergrund

Im Zuge der Entwicklung neuer Produkte und Services müssen Unternehmen ihre Ideen ab einem gewissen Punkt validieren. Das heißt, sie müssen Feedback von potentiellen und echten Kund:innen einholen. Damit ein Produkt bei Markteinführung nicht floppt hat es sich bewährt frühzeitig Tests mit Nutzer:innen durchzuführen, um bereits während der Entwicklungsphase den Nutzen von Produkten aus Kundensicht zu erhöhen und somit die Wahrscheinlichkeit eines Misserfolgs bei Einführung am Markt zu reduzieren.

Lehrformate und Veranstaltungen können als Produkte bzw. als Service wahrgenommen werden. Für sie müssen u. a. Verantwortliche für Planung, Durchführung und Nachbereitung ernannt werden, zu Beginn Lehr- und Lehrziele definiert werden, die anvisierten Zielgruppen (z. B. Studierende, Fachkräfte) müssen festgelegt und verstanden werden, der Aufbau und Ablauf der Veranstaltung, sowie unterstützende Materialien und Werkzeuge bewertet, erstellt und ausgewählt werden. Vor einer Veranstaltung muss Werbung gemacht werden, um Aufmerksamkeit für das eigene Angebot zu schaffen. Denn ohne Nachfrage fehlen ausreichend Teilnehmende bei Durchführung. Das kann u. a. dazu führen, dass gewisse Lehrkonzepte (Peer Feedback, Spiele, Gruppenarbeiten) nicht funktionieren. Während und nach der Durchführung sollte Feedback erhoben werden, um kontinuierlich zu überprüfen, ob die Veranstaltung ihre gesetzten Ziele erreicht. Davon ausgehend kann die Veranstaltung per se, d. h. das Produkt, verbessert werden. Ebenso kann die Art und Weise des Designens und Durchführens der Veranstaltung, d. h. der Prozess, verbessert werden. Für die Verbesserung des Produkts und des Prozesses sind Instrumente zur Evaluation und für Feedback essentiell.

Feedback aus Sicht von Studierenden, Azubis, Angestellten oder anderen Stakeholder:innen kann hierbei nahezu in jeder Phase des Angebots- bzw. Lehrveranstaltungsmanagements erhoben werden und so die Entscheidungen von Designer:innen und Durchführenden unterstützen. So ist es beispielsweise wichtig zu wissen, was bei der erstmaligen Durchführung eines Kurses gut und schlecht lief, um die Erkenntnisse bei weiteren Durchführungen zu bedenken: Lag es an den Durchführenden? … am Material? … am Setting? Dabei kann Feedback individuell oder kollektiv erhoben werden. Manchmal ist es geeignet einzelne Teilnehmende zu befragen und manchmal Fragen ins Plenum zu geben. Daneben ist es nicht immer sinnvoll eine Abfrage synchron, bspw. während einer Veranstaltung, durchzuführen. Auch asynchrone Evaluationen können sinnvoll sein, bei denen Teilnehmende so viel Zeit haben, wie nötig, und ohne Druck Evaluationen durchführen können. Schließlich lässt sich auch noch danach unterscheiden, ob Teilnehmende viel Text produzieren oder nur ein paar Kreuzchen setzen bei der Evaluation.

Letztlich kommt es immer stark auf das Ziel der Evaluation an. Davon ausgehend sollten Entscheidungen bei Planung, Durchführung und Nachbereitung getroffen werden.

2. Beschreibung des Formats

Nachfolgend beschreiben wir eine Reihe von Evaluations- und Feedbackinstrumenten, die wir bei ProXLab-Veranstaltungen eingesetzt haben.

Mentimeter, Pingo

Manchmal ist es wichtig für Moderator:innen von Events, dass sie ein Gespür dafür erhalten, wie die Stimmung in einer Sitzung ist oder wie das aktuelle Meinungsbild ist. Alternativ ist es für Lehrende manchmal interessant zu wissen, wie sich die Teilnehmenden zu einer Frages positionieren oder welche Hypothesen sie für stärker oder schwächer halten.

Was in analogen Settings noch relativ gut auf zwischenmenschlicher Ebene geschehen kann, ist in virtuellen Umgebungen wie ZOOM-Konferenzen eher schwierig. Hier fehlt oft der visuelle Kanal, d. h. die Kameras der teilnehmenden Studierenden sind ausgeschaltet und Moderator:innen erhalten kein Feedback per Mimik.

In diesen Fällen kann es hilfreich sein, wenn Moderator:innen, Trainer:innen oder Lehrende auf einfach und schnell einzusetzende Tools für Feedack-Generation zurückgreifen können. Damit sind sie in der Lage digital-unterstützt Live-Feedback zu Inhalten des laufenden Events von der aktuellen Teilnehmerschaft zu erheben. Beispiele für solche Tools sind Mentimeter oder Pingo.

Wir haben diese Tools eingesetzt, um in Formaten wie Meet & Talk sowie Seminaren zu Beginn der Veranstaltungen grobe Erwartungen einzusammeln, um uns bei der Durchführung daran zu orientieren. Während Veranstaltungen war es nützlich Menti u. a. bei Diskussionen mit geladenen Gästen dafür einzusetzen Argumente zu gewichten. Hierfür konnten Teilnehmende in ZOOM-Sitzungen für bestimmte Argumente stimmen und die Gäse konnten live dazu Stellung beziehen und reagieren. Am Ende von Veranstaltungen waren die Tools gut geeignet, um zu prüfen, welche Erwartungen erfüllt bzw. nicht-erfüllt wurden und wie die Veranstaltungsreihe noch besser gestaltet werden kann.

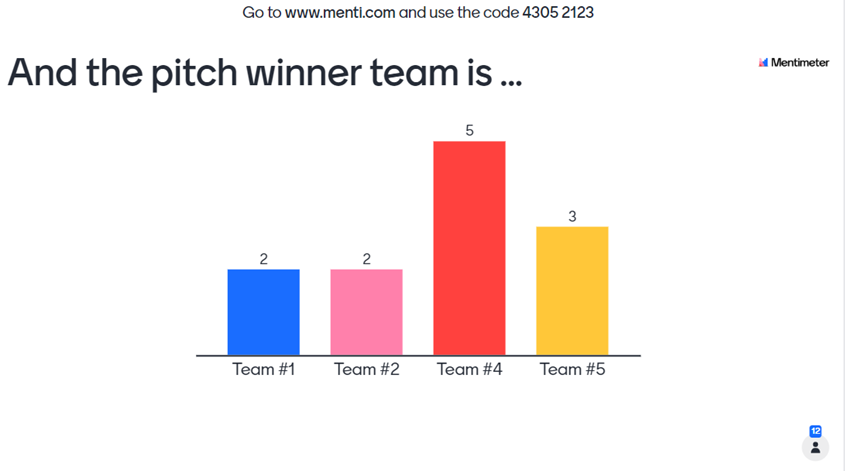

Bei der Digitaltagchallenge 2021 haben wir Mentimeter für die Preisverleihung eingesetzt. Hierzu wurde ein Code generiert, der von jedem internetfähigen Gerät per Browser genutzt werden konnte, um für das Gewinner-Team zu voten. Am unteren rechten Rand kann man erkennen, wie viele teilnehmende Bewerter:innen es gab. In diesem Fall hat klar Team 4 gewonnen. Am Ende der Veranstaltung wurde gelobt, dass wirklich alle Teilnehmenden interaktiv beteiligt waren am finalen Event. Das kann insbesondere für Veranstaltungen interessant sein, die eher schwache Beteiligungen aufweisen oder die Inhalte besitzen, für die sich Teilnehmende nur schwer motivieren können.

Die Tools sind zugänglich unter https://www.menti.com/ sowie https://pingo.coactum.de/.

ZOOM-Umfragen, BBB-Umfragen

Umfragen können oft auch direkt „mit Bordmitteln“ der Videokonferenz-Software durchgeführt werden. Das birgt Vorteile. So müssen nicht externe Tools vorbereitet und verwendet werden. Teilnehmende müssen nicht die Anwendung verlassen und sind weniger verwirrt. Auch die Auswertung der Ergebnisse wird direkt vollzogen und das Ergebnis im gleichen Fenster angezeigt.

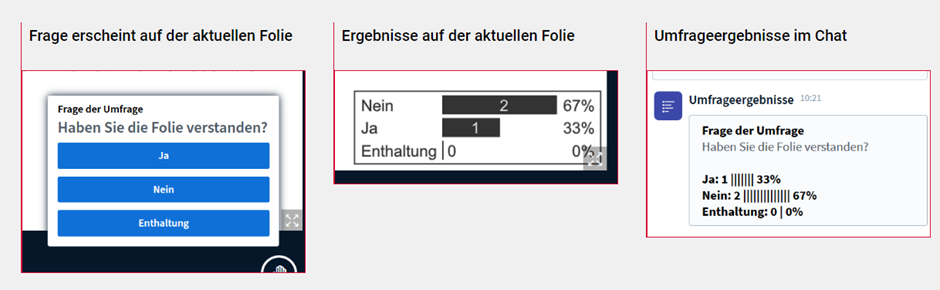

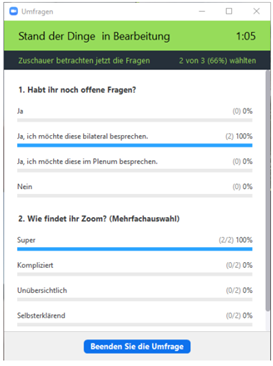

Zwei Möglichkeiten hierfür bieten sich in den Konferenz-Softwares von ZOOM und BigBlueButton (BBB). In BBB sieht es für Teilnehmende dann derart aus:

In ZOOM sehen Umfragen und deren Ergebnisse beispielsweise so aus:

Wer sich für die Verwendung in eigenen Veranstaltungen interessiert, der findet hier nützliche weiterführende Informationen mit gut beschriebenen Anleitungen:

- https://blog.hwr-berlin.de/elerner/neue-umfragemoeglichkeiten-big-blue-button/

- https://ebooks.hslu.ch/sonstigetools/wp-content/uploads/173/2020/07/Zoom-Breakout-Umfragen.pdf

Zugang zu den Anwendungen gibt es unter https://bigbluebutton.org/ sowie www.zoom.us.

MIRO-Voting

Um Feedback-Prozesse entlang aller Phasen des Produktmanagements zu unterstützen, kann Remote Feedback eingesetzt werden. Damit ist gemeint, dass Daten von Stakeholder:innen des Produkts erhoben werden, die nicht am gleichen Ort sind, wie die Forscher:innen. Das kann asynchron und synchron passieren, bspw. bei einer Live-Demo über ZOOM. Noch billiger ist es aber, wenn Feedback asynchron erhoben werden kann.

Das geht bspw. über MIRO-Boards, deren Link an eine nahezu unbegrenzte Zahl von Tester:innen verteilt wird, die dann – je nach persönlicher Verfügbarkeit und Präferenz – ihr Feedback zu Artefakten (Ideen, Produkten, Services etc.) direkt auf dem MIRO-Board abgeben. Aufgrund der Vorstrukturierung des Boards und dem direkten Sammeln entfallen einige aufwendige Prozesse für Forscher:innen aus Design- und Produktabteilung. Durch die Einheitlichkeit können verschiedene Versionen des Boards für verschiedene Zielgruppen parallel bereitgestellt werden, wodurch ein noch effizienterer Produktforschungsprozess realisiert werden kann.

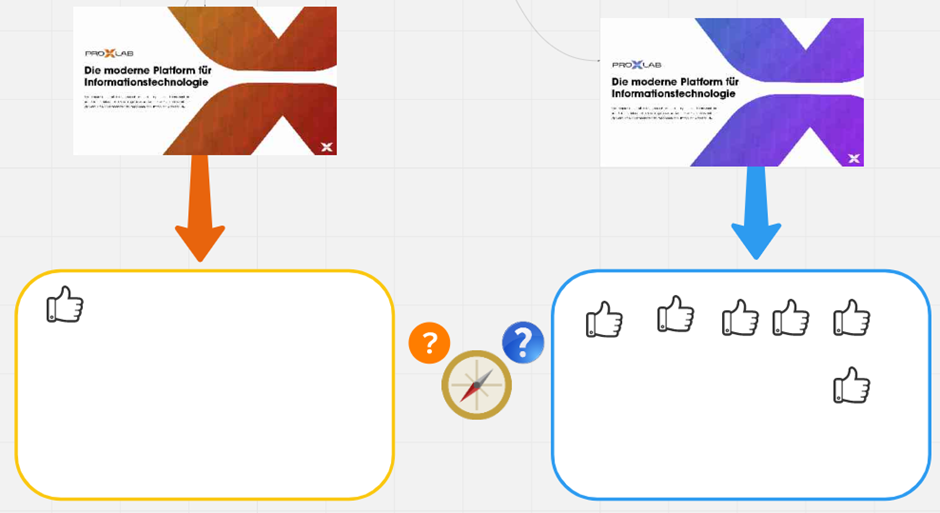

In ProXLab haben wir MIRO-Voting dazu eingesetzt, um asynchron von einer großen Gruppe Studierender Feedback einzuholen, um zu entscheiden, welche Variante eines Logo-Entwurfs eher passt. Anhand einer einfachen Logik konnten wir so ermitteln, dass die rechte, blaue Variante eher geeignet ist. Denn diese hat konkret mehr „Daumen hoch“ erhalten als die linke, orangene Variante. Als Hinweis sei gesagt, dass hier noch zusätzliches Feedback in Form kurzer Kommentare erhoben wurde, um das Wahlergebnis zu verstehen. Schließlich erkennt man, dass MIRO-Voting gut geeignet sein kann, um sich für eine von zwei Varianten zu entscheiden.

Um zum Tool MIRO zu gelangen siehe: www.miro.com/

Unipark, Limesurvey

Wer sehr viele verschiedene Hypothesen in Bezug auf sein Produkt hat, dem ist u. U. ein Fragebogen zu empfehlen. Auf digitale Art und Weise können so viele Fragen verschiedenen Typs generiert werden und per Link mit Teilnehmenden geteilt werden. Eine asynchrone und individuelle Nutzung ist hier erforderlich.

Im Rahmen von ProXLab haben wir nach extracurricularen Events Umfragen an Teilnehmende gesendet. Diese sogenannten „Post-Event-Surveys“ konnten dann asynchron und individuell bearbeitet werden. Wir wollten damit erfahren, inwieweit konkrete Events dazu geeignet waren die Ziele von ProXLab zu unterstützen: Kennenlernen, Vernetzen, Kompetenzen entwickeln etc. Dazu haben wir die Teilnehmenden befragt, inwiefern sie bestimmten Aussagen zustimmen. Daneben haben wir die Möglichkeit geboten in offenen Feldern Kommentare zur Veranstaltung insgesamt frei einzutragen. In Limesurvey sieht das dann beispielsweise so aus:

Wer sehr viele und bestimmte Daten benötigt, der sollte sich eine fragebogenbasierte Umfrage mittels Webtools einmal ansehen. Was wir trotzdem nicht verheimlichen wollen, ist, dass sehr umfangreiche Umfragen die Rücklaufquote nach unten drücken. Ebenso kann ein sehr spätes Versenden der Umfrage nach dem Event ebenso zu geringem Rücklauf führen. Wir haben uns in ProXLab daher ab einem gewissen Punkt dazu entschieden, dass wir Evaluationen u. a. während der Events machen oder im direkten Gespräch qualitatives Feedback einholen. Insbesondere bei Events mit kleinen Gruppen ist es nicht zu empfehlen „schwergewichtige“ Fragebögen zu platzieren.

Zugang zu den Tools gibt es hier https://www.limesurvey.org/de/ und hier https://www.unipark.com/en/

Wer sich zunächst mit den Anwendungen beschäftigen will, der erhält hier Hilfestellungen und Tipps:

PDF-Formular

Eine weitere Variante stellt das Versenden von Formularen dar. Diese werden dann ausgefüllt und zurückgesendet. Diese Variante ist also gut für asynchrone und individuelle Nutzung geeignet.

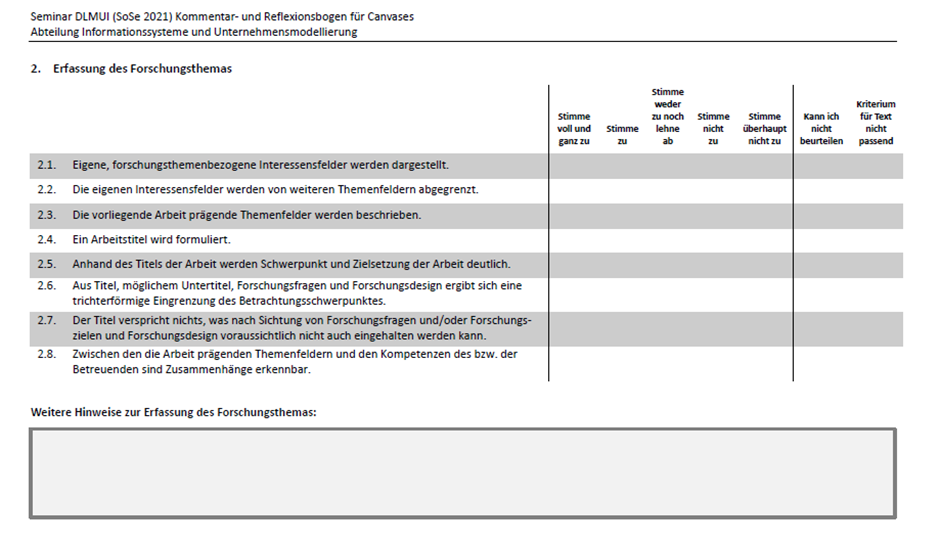

Wir haben das in der Veranstaltung Masterseminar Dienstleistungsmanagement und Innovation im SoSo 2021 erprobt. Alle Studierenden haben von Betreunden per Mail ein PDF-Formular erhalten, dass sie ausfüllen sollten. Sie sollten damit die Arbeiten anderer Studierender im Rahmen von Peer Feedback bewerten. Nach erfolgter Bewertung wurden die Formulare wieder an Betreuende per Mail zurückgesendet, die diese dann auswerteten.

Im Vergleich zu den anderen Live-Evaluationsmöglichkeiten erfordert diese Art der Evaluation viel Aufwand in allen Phasen (Vorbereitung, Durchführung, Nachbereitung). Jedoch kann hiermit auch viel umfangreicheres Datenmaterial generiert werden, da tiefere und komplexere Fragen möglich sind.

Wer selbst ausfüllbare PDF-Formulare kostenlos erstellen möchte, der kann dies mit der Software von Open Office machen. Dazu wird konkret die Software OpenOfficeWriter benötigt.

Zugang zur Software ist hier erhältlich: https://www.openoffice.org/

Eine Anleitung zum Bau von PDF-Formularen mit OpenOfficeWriter findet sich u. a. hier: https://www.heise.de/tipps-tricks/Ausfuellbare-PDF-erstellen-so-geht-s-6148750.html

Zusammenfassung

Mit diesem Beitrag haben wir den Stellenwert von Evaluation und Feedback im Rahmen der Entwicklung und Verbesserung von Produkten erläutert.

Wir haben einen Überblick über Evaluations- und Feedbackinstrumente gegeben und Tipps gegeben, wann sich bestimmte Arten besser oder schlechter eignene. Hier haben wir uns an den Dimensionen der Zeitigkeit (asynchron,synchron) und der Kardinalität (individuell, kollektiv) orientiert.

Wir haben konkrete Tools, d. h. Software, aufgelistet und mit größtenteils eigenen Beispielen und Erfahrungen angereichert. Interessierte erhalten so nützliche „Wegweiser“ auf dem Weg zu eigenen Evaluationen.

Schließlich sei noch gesagt, dass es für die Verwendung jedes Tools zur Evaluation natürlich auch auf den Datenschutz ankommt. Hier empfehlen wir allen Interessent:innen eine solide Prüfung, welche Daten im Verlauf der Evaluation erhoben werden und darauf aufbauend eine kritische Auswahl eines Tools. Nicht für jeden Fall ist jedes Tool gleichermaßen angemessen bzw. zulässig. Beim Einsatz in universitären oder betrieblichen Organisationen empfehlen wir vorab Rücksprache mit zuständigen Infrastruktur- und Datenschutz-verantwortlichen. Denn meist bestehen schon Installationen mit einer bestimmten Software im eigenen Haus und Anwendungsregeln wurden bereits definiert.

Hier gibt’s die Empfehlungen für Evaluations- und Feedbackinstrumente als PDF zum Download: